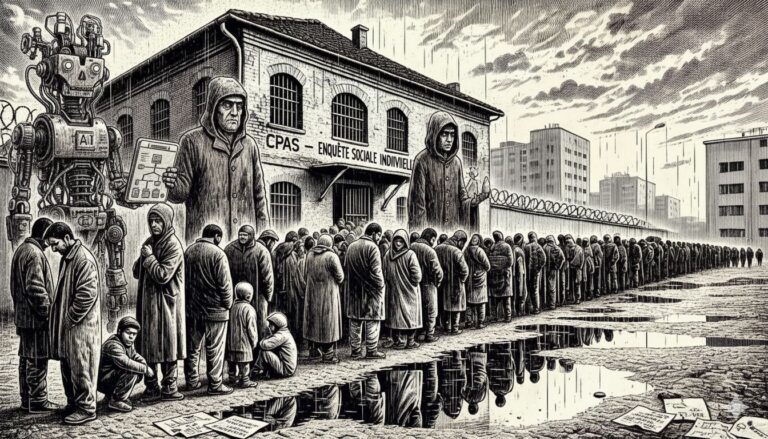

Les courriers viennent de partir. Des milliers de chômeurs de longue durée belges découvrent en ce moment même qu’ils vont perdre leurs allocations. Dans quelques mois, beaucoup d’entre eux franchiront les portes des CPAS, transformant radicalement le paysage de l’aide sociale en Belgique : la sécurité sociale sera dorénavant conditionnée par une enquête sociale individuelle. Cette vague annoncée nous met face à une responsabilité unique : celle d’anticiper et de prévenir les dérives possibles, notamment celles liées à l’usage précipité de l’intelligence artificielle face à cet afflux sans précédent.

Cet article a été publié sous une forme résumée dans le journal Le Soir le 18/9/2025

La tentation de l’automatisation face à la vague qui arrive

Les CPAS le savent : ils vont être submergés. Face à cette crise annoncée, la tentation sera grande de se tourner vers l’intelligence artificielle comme bouée de sauvetage administrative. Le traitement automatisé des dossiers, l’évaluation algorithmique de l’éligibilité, la prédiction des besoins apparaîtront comme des solutions miraculeuses pour gérer l’afflux. Les fournisseurs de solutions technologiques frappent déjà aux portes des CPAS, prêts à vendre leurs systèmes clés en main. Mais avant de céder à cette tentation, il est crucial d’examiner ce qui s’est passé ailleurs.

Au Royaume-Uni, le « système de bien-être numérique » décrit par Amnesty International1 offre un aperçu glaçant de notre futur possible. Des citoyens vulnérables y ont été transformés en simples « points de données ». « Le succès d’une demande peut dépendre davantage de leur capacité à rentrer dans une case ou à remplir certains critères que de leur éligibilité réelle. Dans le cas présent, la technologie a une vision simpliste des réalités complexes des personnes qui minimise leurs besoins, surtout quand elles ne peuvent pas obtenir l’aide dont elles ont besoin d’un humain professionnel du travail social », constate l’organisation.

Les personnes exclues du chômage, déjà fragilisées par l’annonce brutale, risquent de subir une double peine. Après le choc de l’exclusion, elles pourraient se retrouver face à une aide sociale technologiquement intrusive, soit-disant personnalisée, mais en réalité automatisée, déshumanisée. Ce déclencheur de détresse pourrait briser les dernières résistances psychologiques.

Le piège algorithmique qui se prépare

Les algorithmes déployés dans l’urgence reproduiront et amplifieront les biais existants de manière particulièrement pernicieuse. Imaginons le parcours de ces futurs exclus : des parcours professionnels fragmentés, des problèmes de santé non reconnus, des origines sociales ou géographiques défavorisées. Ces profils atypiques risquent d’être systématiquement mal évalués par des systèmes conçus sur des données historiques inadaptées.

Ces nouveaux demandeurs ne correspondent à aucune catégorie préétablie : ni chômeurs classiques, ni travailleurs, ni invalides reconnus. Cette position intermédiaire les plonge dans les angles morts algorithmiques — ces zones d’ombre où les systèmes ne savent pas comment catégoriser, donc comment aider.

L’exemple autrichien2 a été rapidement critiqué pour son traitement inégalitaire des femmes et des personnes handicapées. Le genre féminin et les « obligations de soins » (appliquées uniquement aux femmes) ont reçu un poids négatif, réduisant leur score d’opportunité de réintégration. Le président de l’AMS a tenté de justifier ce biais en disant que l’algorithme « ne faisait que refléter la dure réalité du marché du travail ». Cette justification a été rejetée, et le système déclaré illégal.

L’effacement programmé du lien humain au moment crucial

Dans quelques semaines, des milliers de personnes vivront un moment de rupture profonde. L’arrivée au CPAS après l’exclusion du chômage représente un traumatisme : la honte, la détresse psychologique, la peur de l’inconnu. C’est précisément à ce moment critique que l’accompagnement humain est non pas souhaitable, mais vital.

Or, si nous n’y prenons garde, l’automatisation déployée dans l’urgence remplacera l’écoute empathique par des formulaires en ligne impersonnels, les entretiens personnalisés par des chatbots aux réponses standardisées, et les décisions réfléchies par des scores algorithmiques froids3. Les travailleurs sociaux, déjà en sous-effectif, risquent d’être contraints d’utiliser ces outils comme seule solution, transformant malgré eux leur mission d’accompagnement en simple validation de décisions algorithmiques.

Ces personnes, en état de choc, ont perdu non seulement leurs revenus, mais aussi leur identité sociale, leur estime d’elles-mêmes. Si nous laissons des systèmes automatisés traiter leur détresse, elles risquent de sombrer dans l’invisibilité numérique avant même que nous ayons pu mesurer l’ampleur du désastre humain.

L’opacité algorithmique : une injustice annoncée

Nous pouvons déjà anticiper les scénarios : un algorithme refusera une aide ou orientera vers un dispositif inadapté. La personne, épuisée, ne comprendra pas. Les systèmes d’IA, mis en œuvre dans l’urgence, fonctionneront comme des « boîtes noires », incompréhensibles même pour les travailleurs sociaux.

Cette opacité crée une forme d’arbitraire technologique particulièrement cruelle pour des personnes déjà vulnérables. Après avoir navigué des années dans les méandres du système, rempli d’innombrables formulaires, elles se retrouvent face à des décisions incompréhensibles et incontestables. C’est une négation programmée du droit fondamental à comprendre et à contester.

Agir maintenant : vers une approche éthique et humaine de l’IA dans les CPAS

Le principe du « Human-in-the-Loop » doit être inscrit dès maintenant. L’IA ne doit jamais remplacer le jugement humain dans les décisions d’aide sociale. Les CPAS doivent affirmer ce principe et résister aux sirènes des vendeurs de solutions miracles. Les outils d’IA peuvent aider aux tâches administratives, mais toute décision impactant une vie humaine doit rester sous contrôle d’un travailleur social formé.

Il faut lancer immédiatement les évaluations d’impact sur les droits humains. Il n’est pas trop tard pour anticiper la vulnérabilité psychologique des exclus, leur méconnaissance du système, leur besoin urgent d’accompagnement. Ces évaluations doivent guider la conception de systèmes qui aident, pas excluent.

Exiger la transparence avant le déploiement est capital. Les algorithmes doivent être expliqués dans un langage accessible. Les bénéficiaires doivent avoir le droit de comprendre et de contester les décisions, avec des voies de recours claires, budgétisées dès maintenant.

Il est indispensable de former les équipes dès maintenant. Les travailleurs sociaux doivent comprendre les limites et biais des outils d’IA, non seulement les utiliser. Ils doivent pouvoir contourner les recommandations algorithmiques quand leur expertise humaine le justifie. Il s’agit de les armer pour résister à la pression de l’automatisation.

Impliquer dès aujourd’hui les futurs concernés s’avère essentiel. Les personnes qui ont reçu leur courrier d’exclusion doivent être parties prenantes de la réflexion. Leur voix, leur expérience, leur compréhension des besoins réels sont essentielles pour éviter des systèmes inadaptés.

La vague qui va déferler ne doit pas devenir le prétexte d’une fuite en avant technologique. Au contraire, elle nous met face à la responsabilité de repenser notre système d’aide sociale avant qu’il ne soit trop tard. Nous avons encore quelques semaines, peut-être quelques mois, pour établir les garde-fous nécessaires.

L’IA, si nous la cadrons maintenant, peut libérer du temps précieux. Mais ce temps gagné ne doit pas servir à traiter les gens comme des dossiers. Il doit être sanctuarisé pour l’écoute, l’accompagnement, la reconstruction du lien social.

Les CPAS sont face à un choix historique : soit ils préparent une automatisation déshumanisante, soit ils posent dès aujourd’hui les bases d’un modèle d’aide sociale augmentée, où la technologie sert l’humain, sans le remplacer.

Recommandations urgentes pour les CPAS belges

1. Instaurer un moratoire préventif sur l’automatisation complète des décisions. Aucune décision d’attribution ou de refus ne sera prise uniquement par un algorithme.

2. Créer dès maintenant un comité éthique, avec travailleurs sociaux, représentants des futurs bénéficiaires, experts en éthique et technologie, doté d’un pouvoir de veto réel.

3. Inscrire le droit à l’interaction humaine comme principe inviolable. Chaque futur bénéficiaire doit pouvoir parler à un humain, être écouté, accompagné. Ce droit doit être budgétisé dès maintenant.

4. Auditer tous les systèmes d’IA avant leur déploiement, avec une attention particulière aux profils des exclus du chômage.

5. Affecter un budget équivalent pour le renforcement de l’accompagnement humain à chaque budget prévu pour l’IA.

Il est encore temps d’agir.

Les courriers sont partis, mais les personnes ne sont pas encore arrivées. Nous disposons d’une fenêtre d’opportunité unique pour éviter le désastre annoncé. L’IA peut être un outil utile, mais seulement si nous posons maintenant les garde-fous nécessaires.

Ces questions se posent aujourd’hui, dans chaque CPAS de Belgique. Les réponses que nous y apporterons dans les semaines qui viennent détermineront si les exclus du chômage trouveront au CPAS une main tendue ou un algorithme froid. Le temps presse. La vague arrive. Il est encore temps d’agir, mais plus pour longtemps.

- https://www.amnesty.be/infos/actualites/article/royaume-utilisation-incontrolee-technologies-systemes ↩︎

- https://algorithmwatch.org/en/austrias-employment-agency-ams-rolls-out-discriminatory-algorithm/ ↩︎

- En Belgique, les CPAS reçoivent déjà des “clignotants” de leur administration de tutelle. Ces clignotants identifient des situations jugées anormales vu les croisements de bases de données de l’emploi, de l’intégration sociale, du handicap, etc. Les assistants sociaux doivent alors vérifier si ces clignotants, générés automatiquement, imposent de reconsidérer les droits des bénéficiaires. Le nombre de clignotants a triplé en 5 ans mais plus des 50% d’entre eux sont erronés. Cela génère une charge de travail inutile pour les assistants sociaux et une suspicion généralisée sur les ayants-droit. ↩︎