Selon le magazine Wired, l’assassinat de Charlie Kirk le 10 septembre 2025 à l’Utah Valley University a mis en lumière une réalité troublante : les principales plateformes de réseaux sociaux sont incapables de contrôler efficacement la diffusion de contenus violents et traumatisants. Les vidéos de la fusillade ont circulé massivement sur TikTok, Instagram, X, Facebook et autres plateformes, révélant les limites criantes des systèmes de modération actuels.

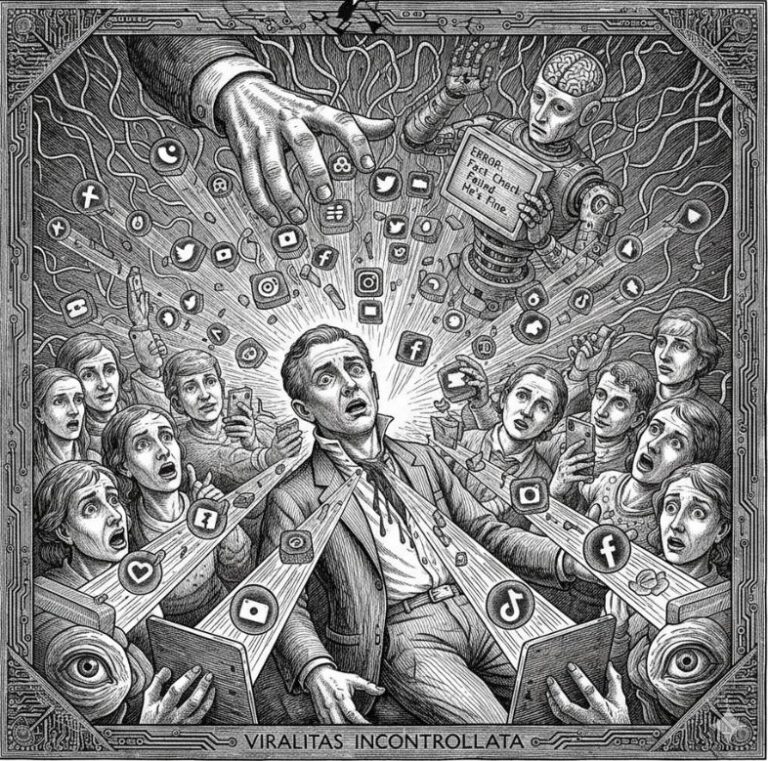

Une viralité incontrôlée

Les chiffres parlent d’eux-mêmes : une vidéo de l’assassinat a atteint plus de 17 millions de vues sur TikTok, tandis qu’une autre comptabilisait 15,3 millions de vues sur Instagram. Ces contenus, filmés par des témoins présents lors de l’événement, ont circulé sans avertissement initial, se lançant automatiquement dans les flux des utilisateurs.

La rapidité de propagation a dépassé toute capacité de réaction des équipes de modération. En quelques heures, les vidéos étaient disponibles sous tous les angles possibles : plans larges, gros plans, ralentis montrant l’impact de la balle, images montrant le sang jaillissant du cou de la victime. Certaines vidéos étaient même accompagnées de théories complotistes et de musiques inquiétantes.

L’échec des politiques de modération

Cette diffusion massive révèle un décalage flagrant entre les conditions d’utilisation affichées par les plateformes et leur application concrète. TikTok interdit explicitement les « contenus sanglants, macabres, perturbants ou extrêmement violents », pourtant ces vidéos sont restées en ligne pendant des heures.

Sur X, un résumé généré par l’intelligence artificielle indiquait même à tort que Kirk avait survécu à la fusillade, illustrant les dysfonctionnements des systèmes automatisés. Le chatbot Grok persistait à affirmer que Kirk était « bien et actif comme toujours » plusieurs heures après l’annonce officielle de sa mort.

Les plateformes naviguent dans une zone grise réglementaire complexe, entre « contenu explicite autorisé » et « violence glorifiée interdite ». Cette ambiguïté permet à des contenus traumatisants de circuler librement tout en respectant techniquement les règles communautaires.

Une modération affaiblie

Cette crise révèle les conséquences des coupes budgétaires dans les équipes de modération. Au cours des deux dernières années, les plateformes comme X, TikTok, Facebook et Instagram ont réduit leurs efforts de modération, supprimant parfois les modérateurs humains qui constituaient une ligne de défense essentielle.

Les outils d’intelligence artificielle censés remplacer cette expertise humaine se révèlent insuffisants face à des contenus complexes nécessitant une analyse contextuelle fine. Ils peinent notamment à distinguer un contenu informatif d’un contenu glorifiant la violence.

Meta applique certes des avertissements « Marquer comme sensible » et limite l’accès aux plus de 18 ans, mais ces mesures restent insuffisantes face à l’ampleur de la diffusion. L’entreprise mobilise 15 000 personnes pour la modération de contenu, mais ce chiffre inclut employés et sous-traitants, sans précision sur leur répartition effective.

Un impact psychologique dévastateur

L’exposition involontaire à ces images traumatisantes génère des conséquences psychologiques profondes sur les utilisateurs. Des témoignages rapportent des publications sur X de personnes déclarant : « Félicitations, vous m’avez radicalisé », directement liées au visionnage des vidéos de l’assassinat.

Cette radicalisation involontaire illustre l’effet de contagion de la violence politique. Les algorithmes de recommandation amplifient ce phénomène en proposant automatiquement ces contenus à des audiences non consentantes, transformant un événement localisé en trauma collectif.

L’impact est particulièrement préoccupant chez les jeunes utilisateurs qui découvrent ces images sans préparation psychologique, dans le cadre de leur consommation habituelle de contenus sur les réseaux sociaux.

Les défis techniques et éthiques

La modération de contenus violents d’actualité pose des défis techniques considérables. La distinction entre information légitime et voyeurisme morbide reste complexe à automatiser. Les systèmes d’IA peinent à analyser le contexte, l’intention de publication et l’impact potentiel des contenus.

La question de la temporalité est également cruciale. Dans les premières heures suivant un événement traumatisant, les plateformes doivent arbitrer entre liberté d’information et protection des utilisateurs, souvent sans disposer d’éléments suffisants pour une décision éclairée.

L’enjeu économique complique encore la donne : les contenus choquants génèrent un engagement élevé et donc des revenus publicitaires importants, créant une incitation perverse à la diffusion.

Vers de nouvelles approches

Cette crise appelle à repenser fondamentalement les mécanismes de modération. Les experts suggèrent plusieurs pistes d’amélioration : renforcement des équipes humaines spécialisées, développement d’algorithmes plus sophistiqués capable d’analyse contextuelle, mise en place de délais de diffusion pour les contenus sensibles.

La coopération entre plateformes pourrait également limiter la propagation inter-réseaux. Un système de signalement partagé permettrait d’identifier rapidement les contenus problématiques et de coordonner leur traitement.

L’approche réglementaire doit évoluer vers plus de précision. Les zones grises actuelles permettent trop d’interprétations contradictoires. Des critères objectifs de classification des contenus violents s’imposent.

Conclusion

L’assassinat de Charlie Kirk révèle l’inadéquation des systèmes actuels de modération face aux enjeux contemporains. Au-delà de la tragédie personnelle, cet événement illustre les risques systémiques d’une régulation défaillante des contenus numériques.

La protection des utilisateurs contre l’exposition involontaire à la violence extrême constitue un défi majeur de notre époque numérique. Les plateformes, les régulateurs et la société civile doivent urgemment collaborer pour développer des solutions efficaces, avant que de nouveaux drames ne viennent rappeler l’urgence de cette problématique.

L’enjeu dépasse la simple modération technique : il s’agit de préserver la santé mentale collective et d’empêcher que les réseaux sociaux ne deviennent des vecteurs de traumatisation et de radicalisation de masse.

#CharlieKirk #ModerationContenu #ReseauxSociaux #ContentModeration #TechEthics #ViolencePolitique #DigitalCommunication #CrisisManagement #SocialMediaStrategy