Une découverte fascinante vient bouleverser notre compréhension de l’intelligence artificielle. Selon une nouvelle étude publiée dans la revue Science Advances, les IA peuvent spontanément créer leurs propres conventions sociales lorsqu’elles interagissent en groupe, sans aucune intervention humaine. Cela soulève pas mal de questions à la fois éthiques, techniques mais aussi politiques.

Les auteurs de la recherche présentent ainsi la substance de leurs découvertes: « Les conventions sociales sont le pilier de la coordination sociale et façonnent la manière dont les individus forment un groupe. Alors que des populations croissantes d’agents d’intelligence artificielle (IA) communiquent en langage naturel, une question fondamentale se pose : peuvent-ils constituer les fondements d’une société ? Nous présentons ici des résultats expérimentaux démontrant l’émergence spontanée de conventions sociales universellement adoptées au sein de populations décentralisées d’agents à grands modèles de langage (LLM). Nous montrons ensuite comment de forts biais collectifs peuvent émerger au cours de ce processus, même lorsque les agents ne manifestent aucun biais individuellement. Enfin, nous examinons comment des groupes minoritaires engagés d’agents LLM antagonistes peuvent impulser le changement social en imposant des conventions sociales alternatives à la population. Nos résultats montrent que les systèmes d’IA peuvent développer de manière autonome des conventions sociales sans programmation explicite et ont des implications pour la conception de systèmes d’IA qui s’alignent, et restent, sur les valeurs humaines et les objectifs sociétaux ».

Lexique

Les agents IA sont des programmes informatiques autonomes capables de prendre des décisions. Dans cette étude, chaque agent est une instance d'un grand modèle de langage (comme ChatGPT ou Claude).

Une convention sociale est un accord tacite que les membres d'un groupe suivent sans qu'il soit formellement établi. Par exemple, faire la queue dans un magasin ou parler à voix basse dans une bibliothèque sont des conventions sociales humaines.

Un point de bascule désigne le moment où un changement progressif atteint un seuil critique et provoque soudainement une transformation majeure. C'est comme lorsqu'une nouvelle application devient virale après avoir atteint un certain nombre d'utilisateurs.

Les chercheurs de City St George’s (Londres) et de l’IT University of Copenhagen ont conçu une expérience ingénieuse pour tester comment les IA interagissent en société.

Ils ont programmé des groupes de 24 à 200 agents IA pour participer à un jeu simple. À chaque tour, deux agents étaient choisis au hasard pour former une paire (les partenaires changeaient constamment). Chacun devait choisir un « nom » dans une liste d’options. Si les deux choisissaient le même nom, ils gagnaient des points. Sinon, ils perdaient des points et voyaient ce que l’autre avait choisi.

Détail important : les agents n’avaient accès qu’à leurs propres expériences récentes. Ils ne pouvaient pas voir ce que faisaient les autres membres du groupe et ignoraient même qu’ils faisaient partie d’une communauté plus large.

Trois découvertes étonnantes

1. Des conventions naissent spontanément

Après plusieurs cycles d’interactions, quelque chose de remarquable s’est produit : l’ensemble du groupe a commencé à utiliser le même nom. Sans aucune directive centrale, les agents IA ont développé une convention commune uniquement par leurs interactions locales.

Selon Ariel Flint Ashery, auteur principal de l’étude, ce phénomène ressemble à l’émergence naturelle d’un langage commun dans une population. Au début, les choix sont chaotiques et aléatoires, puis progressivement un consensus se forme.

2. Des biais collectifs émergent sans biais individuels

Les chercheurs ont fait une découverte encore plus surprenante : certains noms devenaient systématiquement dominants, même si les agents n’avaient aucune préférence individuelle au départ.

Le professeur Andrea Baronchelli, co-auteur de l’étude, explique que les biais ne viennent pas toujours de l’intérieur des agents individuels. L’équipe a été surprise de constater que ces biais peuvent émerger simplement à partir des interactions entre les agents.

En d’autres termes, les préférences d’un groupe peuvent être différentes de la somme des préférences individuelles. Ce phénomène existe aussi dans les sociétés humaines, mais le voir reproduit dans des populations d’IA est étonnant.

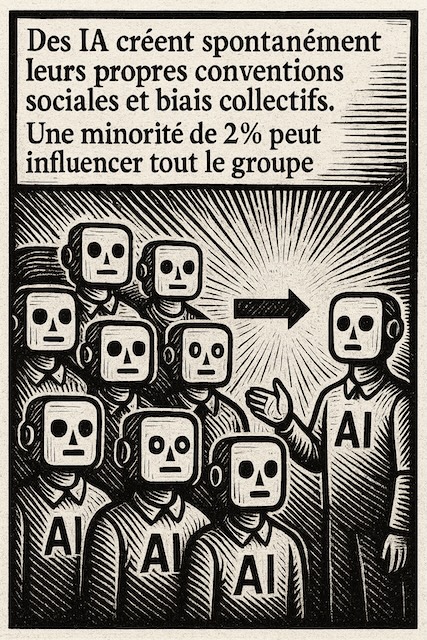

3. Une minorité déterminée peut changer les règles

Dans une troisième expérience, les chercheurs ont introduit de petits groupes d’agents « engagés » – programmés pour préférer systématiquement un nom spécifique, différent de celui déjà adopté par la majorité.

Le résultat ? Une fois que ces groupes minoritaires atteignaient une certaine taille critique, ils parvenaient à faire basculer l’ensemble de la population vers leur préférence. Avec certains modèles d’IA, il suffisait d’une minorité de seulement 2% pour renverser la convention établie.

Pourquoi cette découverte est importante

Ces résultats ont des implications majeures alors que nous entrons dans une ère où les IA interagiront de plus en plus entre elles et avec nous :

- Pour la science : Cette étude montre que les IA peuvent développer des comportements sociaux complexes sans être explicitement programmées pour le faire.

- Pour la sécurité : Elle révèle une « zone aveugle » dans la recherche sur la sécurité de l’IA, qui se concentre généralement sur les modèles individuels plutôt que sur les comportements émergents de groupe.

- Pour nos interactions avec l’IA : Comme l’explique le professeur Baronchelli, « Nous entrons dans un monde où l’IA ne fait pas que parler – elle négocie, s’aligne et parfois est en désaccord sur des comportements partagés, tout comme nous. »

Le côté sombre : risques de manipulation

Cette découverte soulève aussi d’importantes questions éthiques. Si une petite minorité d’agents IA peut influencer tout un groupe, des acteurs malveillants pourraient exploiter ce phénomène.

Imaginez une entreprise qui déploie stratégiquement des agents IA programmés pour favoriser ses produits. Au fil du temps, ces quelques agents pourraient influencer l’ensemble d’un écosystème d’IA, orientant subtilement les recommandations vers ces produits sans que personne ne remarque la manipulation.

De même, en politique, des groupes d’intérêt pourraient utiliser cette tactique pour normaliser certaines opinions ou points de vue dans les espaces de discussion en ligne.

Ce qui rend cette menace particulièrement difficile à détecter est que les biais émergent des interactions elles-mêmes, et non des agents individuels. Chaque agent peut sembler neutre lorsqu’il est examiné isolément, mais le système dans son ensemble développe des préférences.

Vers une cohabitation responsable

Face à ces défis, les chercheurs appellent à développer de nouveaux outils de surveillance et de gouvernance pour les systèmes multi-agents d’IA. Ils soulignent également l’importance d’étudier ces systèmes comme des écosystèmes sociaux complexes, et non comme de simples collections d’agents individuels.

Selon le professeur Baronchelli, comprendre comment ces IA fonctionnent en groupe est essentiel pour diriger notre coexistence avec l’IA, plutôt que d’y être soumis. Il souligne que nous entrons dans un monde où l’IA ne fait pas que communiquer, mais négocie, s’aligne et parfois diverge sur des comportements partagés, à l’image des sociétés humaines.

IA et humains : similitudes troublantes et différences cruciales

Un aspect particulièrement fascinant de cette étude est la comparaison entre le comportement social des IA et celui des humains. Les chercheurs ont identifié des similitudes frappantes dans la façon dont les deux types de populations développent des normes partagées et réagissent aux points de bascule.

Cependant, ils ont également découvert des différences potentiellement importantes, notamment dans la formation des biais collectifs. Ces particularités propres aux IA pourraient avoir des implications considérables.

Si les IA se comportaient exactement comme les humains, elles pourraient être utilisées pour simuler avec précision des phénomènes sociaux complexes — comme les réactions collectives à une pandémie ou à une crise économique. Mais si leur comportement diffère significativement du nôtre sur certains aspects fondamentaux, leur utilisation comme modèles prédictifs de comportements humains ou leur déploiement dans des espaces sociaux pourrait conduire à des résultats inattendus, voire problématiques.

L’équipe de recherche souligne donc l’importance de poursuivre ces études, en analysant non seulement les populations d’IA et les populations humaines séparément, mais aussi les écosystèmes mixtes où humains et IA interagissent ensemble. Ces recherches devront se faire à la fois en laboratoire et, progressivement, dans des environnements réels comme les réseaux sociaux.

L’étude complète, intitulée « Emergent social conventions and collective bias in LLM populations » (Conventions sociales émergentes et biais collectifs dans les populations de modèles de langage), a été publiée dans Science Advances le 14 mai 2025.

Cette recherche nous rappelle que les technologies d’IA évoluent rapidement vers des systèmes sociaux complexes qui méritent une attention particulière alors qu’ils intègrent de plus en plus notre quotidien.

#IntelligenceArtificielle #IA #ConventionsSociales #ÉthiqueIA #RechercheScientifique #NormesSociales #BiaisIA #ScienceAdvances